SEO et l'analyse de logs

Si vous ne savez pas ce qu'est un fichier log et que vous vous intéressez au SEO, il est bon de savoir qu'il s'agit des fichiers journaux où sont enregistrés tous les évènements réalisés sur un serveur web tel qu'Apache, IIS ou Nginx.

Par exemple, dans ce journal, l'ensemble des requêtes auxquelles le serveur a répondu sont listées chronologiquement. C'est une mine d'information qu'il convient d'analyser dans le cadre du référencement, de la sécurité ou d'un audit de site web.

Que contient un fichier log ?

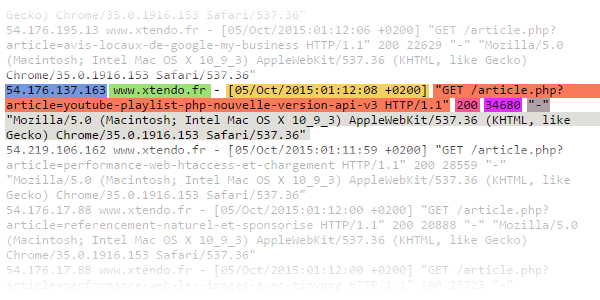

Ci-dessous, quelques lignes d'un fichier log apache issu d'OVH avec les différentes parties d'une ligne de ce journal surlignée. Chaque couleur indique des informations distinctes telles que :

Bleu : l'adresse IP du client demandeur du contenu

Vert : Le nom d'hôte

Jaune : la date et l'heure de la requête

Orange : la requête effectuée ou l'url visitée ainsi que le protocole (HTTP/1.1)

Rose : Le statut de la réponse

Violet : La taille des données servies

Gris foncé : Le User Agent (ici "-" information non disponible)

Gris clair : Le Referer (informations sur le client qui lance la requête)

Selon la configuration du serveur, d'autres informations peuvent être présentes telles que le temps de chargement.

Quel peut-être l'intérêt des fichiers logs ?

Comme vous pouvez le voir, dans ces fichiers il n'y a pas de place pour la poésie... Ces données brutes permettent cependant une analyse qui vous donnera des données statistiques indisponibles dans les outils tels que Google Analytics, Piwick, Urchin...

Quels sont les robots qui visitent votre site ? Et comment crawlent-ils votre site ?

Là où l'enjeu devient majeur, c'est bien sûr pour Google avec GoogleBot et ses petits frères. De quelle manière et à quelle fréquence visitent-ils votre site ?

Quelle image Google a-t-il de votre site internet ?

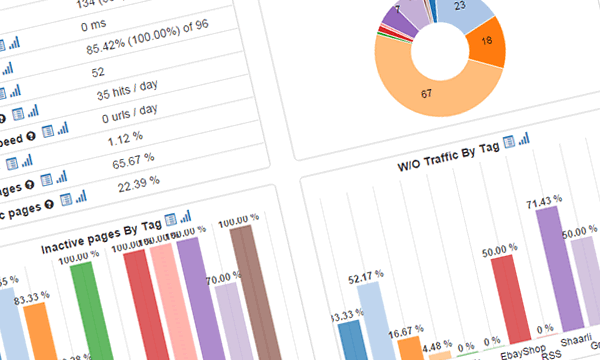

Lors de l'analyse statistique des logs, il s'agit d'obtenir certains KPI tels que :

- Le taux de crawl et sa fréquence

- Les pages non crawlées par Google

- Le taux de crawl global en fonction de la catégorie et de la profondeur des pages

- Le taux de pages actives ou inactives

- Le taux des codes du statut de réponse des requêtes HTTP pour s'assurer que le "200" prédomine sur les "30x" et "40x"

Grace à ces métriques, il est possible de connaitre précisément le rapport entre les pages connues par Google et celles publiées, les pages orphelines ou dupliquées, l'efficience d'une catégorie entre le crawl de Google et les visites obtenues par le référencement, les pages ignorées par Googlebot...

A partir de là, si l'on couple ces données avec d'autres issues d'Analytics ou de PageSpeed des préconisations peuvent être données et des actions de corrections peuvent être menées.

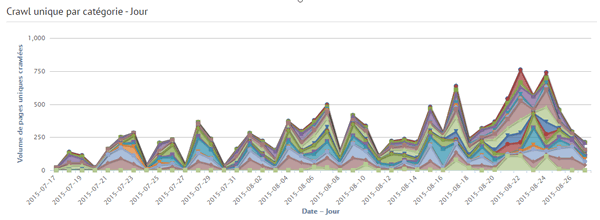

Graphique du volume de crawl de Googlebot sur un site via Kelo.gs

Comment mener cette analyse de données ?

Il existe plusieurs manières de procéder et divers outils à disposition pour réaliser cette tâche

A la main avec Excel :

Si vous avez de petits volumes données à analyser sur de courtes périodes Excel peut faire l'affaire cependant si votre site fait plus de 500 visites jour sur un mois le volume de données à traiter va rapidement mettre le tableur à genoux. Il faudra donc filtrer en amont les informations à traiter ou passer à des outils dédiés.

Avec un logiciel desktop :

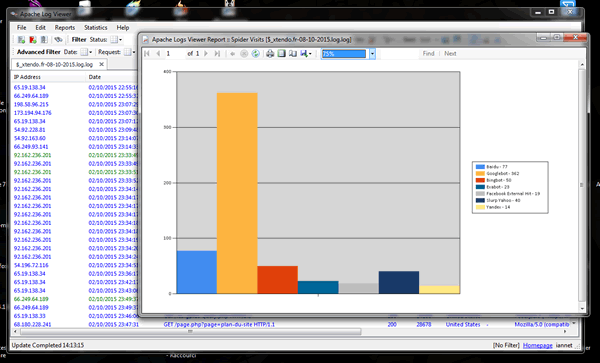

Personnellement, j'utilisais des outils tels que "Apache Logs Viewer" qui permet de fines analyses et un reporting graphique sur de nombreux points.

Capture d'écran de Apache Logs Viewer : Passages des crawlers sur le site

Avec des outils en ligne :

Il existe de nombreux services en ligne qui se chargent de vous fournirent des analyses directement exploitables pour le SEO à partir de vos logs :

- Botify : très complet et particulièrement pertinent, son principal défaut est son prix qui le rend difficilement accessible au petites structures.

- Kelo.gs : Plus abordable et en développement continu, les développeurs (Disponibles et à l'écoute des utilisateurs) mettent en place des KPI selon vos souhaits qui vous permettent d'avoir une vision graphique et clair du crawl de Googlebot sur votre site ainsi que des visites SEO issues de Google.

- Spiderlog : En béta gratuite actuellement, cet outil vaut le détour et est très complet, c'est actuellement mon préféré avec Kelo.gs, il permet une catégorisation des contenus via des "tags" et autorise le traitement de gros volumes de données tout en gardant une grande lisibilité.

En ligne de commande :

Pour les plus techniciens et si votre site est sur un serveur dédié je vous conseille cet excellent article de Paul Courtois (un des créateurs de Kelo.gs) sur l'analyse et l'extraction de données en ligne de commande > http://blog.pole-conseils.com/maitrisez-lanalyse-de-logs-les-5-commandes-indispensables-pour-devenir-autonome/ C'est une vraie mine !

Sur serveur dédié :

Watussi Box : Créé par Jean-Benoît Moingt cet outil est à installer sur son serveur. Il fournit une centaine d’indicateurs qui permettent d'étudier le comportement de Googlebot et la santé de d'un site web.

Pour conclure :

L'analyse de logs est un indispensable en référencement et éclaire le SEO ou l'administrateur d'un site web sur l'état d'un site web et la manière dont les robots le perçoivent. Elle permet de soulever des problèmes jusqu'alors invisibles et insoupçonnés.

Par ailleurs, elle permet aussi d'en apprendre beaucoup sur le fonctionnement même des moteurs de recherche et leurs crawleurs. C'est ainsi qu'il y a quelques semaines j'apprenais que Google s'intéressait de prêt aux associations entre un site web et une application mobile IOS...

Oui comme vous pouvez le comprendre l'analyse de log est stratégique !

Liens vers les outils :

- http://www.apacheviewer.com/

- https://www.botify.com/

- http://kelo.gs/

- https://spiderlog.serphacker.com/fr/

- http://box.watussi.fr/

Par Johan Puisais - Xtendo : création de site internet Poitiers

Pour continuer votre lecture sur la thématique SEO référencement

- Traduction du guide pour Quality Raters de Google

- Xserp : des résultats sans personnalisation par Google

- Livre : Techniques de référencement web

Tags : SEO référencement, Audit site internet, Visibilité internet,

Commenter et noter cet article